von André Krischer

Algorithmen als „Weapons of Math Destruction“

„Weapons of Math Destruction“, kurz: WMD – mit diesem ingeniösen Label bezeichnet Cathy O’Neil Algorithmen, die in immer mehr Lebensbereiche eingreifen.[1] Das 2015 erschienene Buch der amerikanischen Mathematikerin, ehemaligen Investmentbankerin und politischen Aktivistin ist vor kurzem auch auf Deutsch erschienen – und liest sich wie eine Warnung: Wer z.B. heute in den Vereinigten Staaten einen Kredit aufnehmen oder eine Versicherung abschließen wolle, sei nicht länger abhängig von der örtlichen Bankberater*In oder Versicherungsagent*In, die ihre Entscheidungen immer auch mit ‚Bauchgefühl‘ treffen und dabei nicht selten ethnische oder soziale Vorurteile einfließen lassen. Vielmehr übernehmen diese Entscheidung nun Algorithmen, also Computerprogramme.

Dieser Umstellung vom Menschen auf die Automaten liege nicht zuletzt die Absicht zugrunde, derartige Vorurteile, also kognitive Verzerrungen, aus der Entscheidungsbildung herauszuhalten. Diese gute Absicht habe aber eine Reihe nicht beabsichtigter Folgen: Denn tatsächlich, so O’Neil, tragen algorithmisierte Entscheidungen eher zur Ausweitung der sozialen Unterschiede bei. Algorithmen nutzen Big Data – aus unterschiedlichen Quellen stammende Datenmengen – um Personen zu klassifizieren und bestimmten Gruppen zuzuordnen: Zahlt die Bewerberin ihre Rechnungen stets fristgerecht? Hat sie einen festen Beruf? Lebt sie in einem bürgerlichen Viertel oder einem sozialen Brennpunkt? Hat sie Vorstrafen?

Gerade weil sie ohne konkretes Ansehen der Person auskommen, tendieren WMDs nun dazu, vielfach schlechte Prognosen zu errechnen. Wenn die Postleitzahl auf eine als problematisch eingestufte Nachbarschaft verweise oder, was nicht selten vorkomme, eine namensgleiche Person im Vorstrafenregister auftauche, bekomme die Bewerberin keinen Kredit und keine Versicherung. Solche Korrelationen und Falschinformationen – also algorithmische Verzerrungen – können, so O’Neil, durch menschliche Entscheider besser eingeordnet werden. Wenn sie aber nach ihrem Schema operierten, trügen WMDs gerade nicht dazu bei, „poverty cycles“ zu durchbrechen, sondern sie zu zementieren. Umgekehrt führen positive Kreditentscheidungen auch zu besseren Einstufungen in anderen Bewertungssystemen: „Good credit scores are sexy“, sagt sich und anderen User*Innen etwa der Algorithmus auf einer Dating-Plattform – und prämiert dieses Scoring mit einem der vorderen Plätze.

Über die Macht der Algorithmen wird auch in Deutschland diskutiert, nicht erst seit O’Neils Buch, aber seit seinem Erscheinen intensiver.[2] Die Machtfrage stellt sich auch für Politik: Lassen sich Algorithmen rechtlich regulieren? Wer ist für die Folgen ihrer Entscheidungen im rechtlichen Sinne verantwortlich? Die Grundstimmung der Diskussion ist jedenfalls pessimistisch. Der ehemalige Telekom-Vorstand und FDP-Politiker Thomas Sattelberger schreibt z.B. in ZEIT ONLINE: „Wir begeben uns freiwillig in die Abhängigkeit von Algorithmen. Wir lassen uns sogar die Entscheidung, in wen wir uns verlieben, von Computerprogrammen ausrechnen. Auch das ist ein Indiz für eine defensive Entscheidungskultur.“[3]

Ohne Zweifel handelt es sich beim Machtzuwachs der Algorithmen um eine brisante Entwicklung.[4] Aber handelt es sich bei dem, was sie tun, auch um Entscheidungen? Bei allen Unterschieden der Diskussion im Detail wird den Algorithmen jedenfalls genau diese Fähigkeit zugeschrieben. Und es ist nur diese Detailfrage – und nicht etwa das gesellschaftsverändernde oder -bedrohende Potenzial der Algorithmen im Großen und Ganzen –, die mich in diesem Beitrag interessiert.

Was tun Algorithmen – und was heißt Entscheiden?

Ob Algorithmen das können – nämlich Entscheiden, kommt darauf an, was man einerseits unter einem Algorithmus und andererseits unter Entscheiden versteht.

Ein Algorithmus wird üblicherweise definiert als „eine eindeutige Handlungsvorschrift zur Lösung eines Problems oder einer Klasse von Problemen. Algorithmen bestehen aus endlich vielen, wohldefinierten Einzelschritten. […] Bei der Problemlösung wird eine bestimmte Eingabe in eine bestimmte Ausgabe überführt.“[5] Sofern der Algorithmus von einem Computerprogramm ausgeführt wird[6], basiert diese Überführung auf einem mathematischen oder zumindest logischen Kalkül. Wohldefinierte Handlungsvorschriften, logische Kalküle zur Überführung der Eingaben in die Ausgabe: Wenn Algorithmen entscheiden, dann rechnen sie.

Im Lichte einer definitorischen Tradition, die von postmodernen Theoretikern (Günther Ortmann, Jacques Derrida, Ernesto Laclau) über Niklas Luhmann, Heinz von Foerster, Hermann Lübbe und Carl Schmitt bis auf Søren Kierkegaard zurückgeht[7], handelt es sich allerdings genau dann, wenn auch gerechnet werden kann, nicht um eine Entscheidung. In den Worten von Ortmann: „Entscheidungen sind genau dann nötig, wenn sie unmöglich sind – unmöglich im Sinne guter, schlüssiger Begründung. Es ist gerade der Mangel an Begründung, der uns eine Entscheidung abverlangt. […] Entscheidungen, die diesen Namen verdienen, sind immer mit Unsicherheit, Mehrdeutigkeit und Kontingenz konfrontiert.“[8] Entsprechend haben Entscheidungsvorgänge stets mit Unsicherheitsabsorption, nachträglicher Sinnstiftung, Rationalitätsfassaden, der Differenz von Herstellung und Darstellung usf. zu tun. Zwischen all den mühsam zusammengesuchten Informationen, sorgfältig evaluierten Alternativen und rationalen Gründen auf der einen und der Entscheidung auf der anderen Seite bleibt ein Hiatus, der nur „dezisionistisch übersprungen“ werden kann.[9] Für solche Sprünge sind Automaten aber nicht zu haben.

Ist damit das Problem gelöst? Bedient man sich in der Diskussion über die Macht der Algorithmen letztlich nur eines inadäquaten Entscheidungsbegriffs – übrigens auch im Englischen, wo es heißt algorithms decide?[10] Im Alltagsdiskurs wird ja sehr vielen Dingen in metaphorischer Weise zugesprochen, etwas entscheiden oder wählen zu können (‚Das Feuer wählte sich willkürlich seine Opfer‘), obwohl man das eigentlich gar nicht so meint. Müsste es daher nicht auch korrekterweise heißen: Algorithmen ‚rechnen‘, ‚entscheiden‘ aber müssen immer noch die Menschen?[11]

Oder aber ist der Entscheidungsbegriff der Philosoph*Innen, Soziolog*Innen und Organisationstheoretiker*Innen zu eng gefasst, gleichsam zu ‚humanistisch‘ und zu sehr auf sinnverarbeitende Systeme gemünzt? Dafür, das Problem zunächst (!) hier, auf Seiten der soziologisch-philosophischen Entscheidungstheorie zu verorten, gibt es mindestens zwei Gründe, einen empirischen und einen systematischen: Denn wie immer man das begrifflich auch fasst – dass Automaten an Entscheidungen beteiligt sind, lässt sich kaum in Abrede stellen. Die Popularität von Praxeologie, Science and Technology Studies, Akteur-Netzwerk-Theorien (ANT) oder material turn ist wiederum ein Indiz dafür, dass es vielen Kulturwissenschaftler*Innen nicht länger als plausibel erscheinen, das Soziale allein aus dem Sozialen zu erklären, Kultur allein auf Bedeutungsgewebe zurückzuführen oder Kommunikation allein in Zeichen und Symbolen zu verorten.[12]

Was es mit dem Entscheiden der Algorithmen auf sich hat, wird erst dann klar, wenn wir nicht länger dichotomisch zwischen ‚Kultur‘ und ‚Natur‘, zwischen der Welt des Sozialen und der Welt des Technischen und Artifiziellen, zwischen Menschen und Automaten unterscheiden. Diese Dichotomie ist allerdings nicht nur seit Descartes tief in unserem Denken verankert, sie wird auch im populären Diskurs durch Filme wie die ‚Matrix‘-Trilogie oder eben die Berichterstattung über Algorithmen beständig reproduziert.[13] Wenn es uns nun gelingt, die Rolle von Artefakten bei Prozessen des Entscheidens genauer zu bestimmen, trägt dies auch dazu bei, dieses Entscheiden selbst besser zu verstehen.

Artifizielle Partizipanden des Entscheidens

Das Problem wird also auch nicht damit gelöst, wenn man davon ausgeht, dass Entscheidungen auf Automaten verlagert werden[14], dass also Automaten anstelle von Menschen entscheiden. Denn dass die Dinge das Soziale konstitutiv prägen, dass sie allenthalben, wie Bruno Latour es formuliert, „einen Unterschied“ machen[15], heißt nicht, dass sie auch eine autonome Handlungsmacht besitzen. Es geht nicht darum, die Objekte zu Subjekten zu machen, sondern darum, sie sich als „Partizipanden“ eines verteilten Vollzugsgeschehens, vorzustellen, einer koaktiven Praxis.[16]

Bezogen auf Entscheiden impliziert diese partizipatorisch-praktische Perspektive zunächst, dass es sich dabei weder um eine Aneinanderreihung von (subjektiven) Einzelentscheidungen handelt, noch, dass es dabei lediglich um die Vorbereitung einer abschließenden, ‚großen‘ Entscheidung durch das Sammeln von Informationen, das Evaluieren von Alternativen oder das Debattieren von Argumenten oder Positionen geht. Entscheiden vollzieht sich vielmehr als ein zugleich selektiver und produktiver Prozess.[17] Beide Dimensionen lassen sich nur analytisch, aber nicht praktisch trennen.

Selektion heißt Reduktion von Komplexität: Bestimmte Möglichkeiten werden weiterverfolgt, andere nicht; bestimmte Pfade werden genommen, andere nicht. Dass beim Entscheiden fortlaufend selektiert wird, hat zur Folge, dass Vieldeutigkeiten, Paradoxien und Kontingenz vielfach am Beginn eines Prozesses stehen und nicht, wie die postmodernen Theorie des Entscheidens lehren, an dessen Ende – selbst wenn dies aus dramaturgischen Gründen häufig so inszeniert wird. Im Prozess des Entscheides ist die abschließende Entscheidung nur eine Selektion von vielen. Zur Entscheidung wird sie durch ihre explizite Thematisierung und symbolisch-expressive Hervorhebung.[18]

Produktion heißt wiederum, dass beim Entscheiden nicht nur Vorhandenes genutzt wird, sondern auch Neues entsteht. Positionen, Alternativen, Perspektiven sind nicht schon gegeben, sondern werden im Laufe des Prozesses erst erzeugt. Diese Positionen, Alternativen und Perspektiven sind keine bloß geistigen Phänomene, sondern haben ihre konkreten, medialen und materialen Substrate. Sie werden aufgeschrieben, gedruckt, gespeichert, visualisiert oder digitalisiert. Nicht selektierte Möglichkeiten landen dagegen, als zerknüllter Zettel oder als gelöschte Datei, im realen oder digitalen Papierkorb.

Entscheiden stellt sich also, wie andere Praktiken auch, als „Zusammenspiel und Zusammenwirken“ von menschlichen Akteuren und unterschiedlichen Objekten und Artefakten dar.[19] Diese ermöglichen, vermitteln, übersetzen, erzwingen, erleichtern, verstärken, autorisieren oder vernetzen praktische Aktivitäten, sie rahmen den Prozess, halten ihn am Laufen und leiten von einer Situation oder Sequenz zu einer anderen über.[20] Mit Latour gesprochen ist Entscheiden nicht „das Vermögen von Menschen, sondern das Vermögen einer Verbindung von Aktanten“ menschlicher und nicht-menschlicher Art.[21] Gebäude, Büros, Amtskleider, Schreib- und Aktenmaterialien, Archive oder auch die Infrastrukturen der Kommunikation (Postkutsche, Glasfaserkabel) sind offensichtliche Beispiele für den artifiziellen Part beim Entscheiden als einer Koaktivität.[22] Zu den Artefakten zählt aber nicht nur derartige ‚Hardware‘, sondern auch Software, zählen Computerprogramme und programmierte Algorithmen[23], die im Prozess des Entscheidens ebenso Möglichkeiten selektieren und Entscheidensbeiträge produzieren wie menschliche Akteure auch, die menschlichen ‚Entscheidern‘ zuarbeiten und von ihnen wiederum mit Daten beliefert werden. Niklas Luhmann hatte diese Koaktivität in einer verwaltungssoziologischen Arbeit aus der Mitte der 1960er Jahre bereits klar vor Augen, als er schrieb, dass in computerisierten Bürokratien Juristen „mit der Maschine ‚Hand in Hand‘ arbeiten“.[24]

Auf einer Tagung des SFB 1150 hat der Gießener Soziologe Jürgen Schraten am Beispiel von Kreditentscheidungen diese Koaktivität menschlicher und artifizieller Partizipanden kürzlich sehr klar herausgearbeitet.[25] Wenn Banken heute über gewöhnliche Privatkredite (etwa für den Hausbau) entscheiden, dann wird hier, anders als O’Neil es darstellt, kein Algorithmus anstelle eines Bankberaters tätig. Vielmehr involviert diese Praxis eine ganze Reihe unterschiedlicher und räumlich disparater Partizipanden. Ohne Anspruch auf Vollständigkeit seien genannt: Antragsteller, die ihren Antrag am heimische PC ausfüllen oder hochladen; Berater in den Bankfilialen, die das an ihren Rechnern herunterladen und sichten, die (computerunterstützte) Berechnungen anfertigen, telefonieren, mailen, Schufa- und andere Auskünfte einholen, die die Antragsteller treffen (um z.B. subjektive Eindrücke zu gewinnen), die Leitzinsen, rechtliche und betriebliche Vorgaben prüfen; Computer, die mit Daten ‚gefüttert‘ werden, die Vorgaben erteilen und automatisiert mit Computern anderer Finanzinstitutionen interagieren[26]; Vorgesetzte, die das Ergebnis prüfen und genehmigen, wiederum vom Computer unterstützt.

Das Entscheiden über einen Hausbau-Kredit ist am Ende nicht die Leistung eines dieser Partizipanden – sei es der Computer, seien es die Algorithmen, sei es der Berater, sei es der Vorgesetzte. Es ist vielmehr das Resultat von Koaktivität und Vernetzung . Komplexe Kreditentscheidungen entstehen in einem Netzwerk aus humanen und materiellen Aktanten, die in unterschiedlicher Weise selektieren und produzieren.[27] Vielleicht meint der Vorgesetzte, dass er am Ende die Entscheidung ganz allein ‚trifft‘. Vielleicht haben auch alle anderen Beteiligten diesen Eindruck und stützen den Vorgesetzten aktiv darin. Vielleicht legen auch die Rahmenbedingungen diesen Eindruck nahe. Tatsächlich aber thematisiert der Vorgesetzte nur eine von vielen der im Netzwerk produzierten Selektionen, die ihm dann als Entscheidung zugeschrieben wird. Genauso wenig aber treffen computerisierte Algorithmen bereits die Entscheidungen, weil ihre Selektionen nur durch die Vermittlungs-, Übersetzungs- und Thematisierungsleistungen anderer Partizipanden kommunikative Anschlussfähigkeit und Geltung erlangen können. Sinnstiftung und Sinnverarbeitung bleiben menschliche Vermögen.

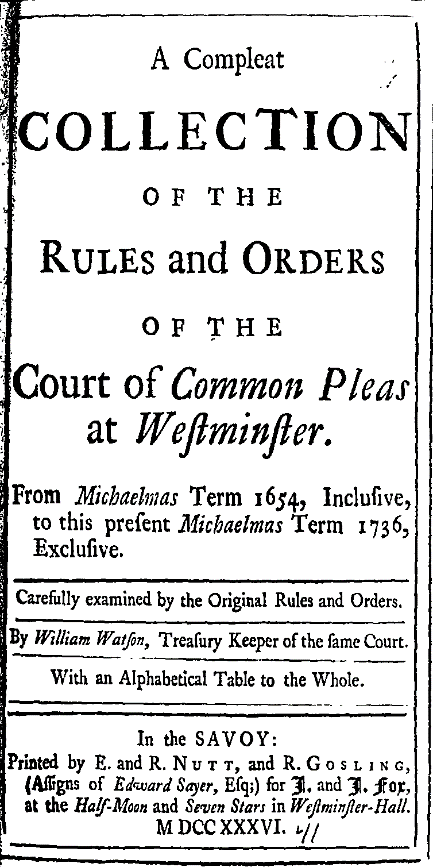

Wenn wir sie als Artefakte betrachtet, ist die Partizipation von Algorithmen beim Entscheiden also im Grunde keineswegs außergewöhnlich. Sie ist auch nicht neu. Algorithmen oder zumindest funktionale Äquivalente, die ebenfalls „eindeutige Handlungsvorschrift zur Lösung eines Problems oder einer Klasse von Problemen“[28] beinhalten, finden sich beispielsweise schon in der frühneuzeitlichen Rechtspraxis, wenn man hier etwa an die ‚gesetzliche Beweistheorie‘ des Inquisitionsprozesses oder an die Präzedenzfälle im Common Law denkt – und an deren medial-materialen Substrate.

Verteilungskonflikte zwischen menschlichen und artifiziellen Partizipanden

Das heißt aber nicht, dass die computerbasierten Algorithmen kein Problem wären. O’Neil und andere haben mit ihren Warnungen fraglos Recht. Es geht nur darum, das Verhältnis von artifiziellem Algorithmus und Entscheiden besser zu verstehen (und damit das Entscheiden selbst auch). Die Partizipation an Praktiken muss sich keineswegs harmonisch darstellen. Ohne Frage gibt es auch hier um Macht- und Verteilungskonflikte. Und auch um Deutungskonflikte: Denn die oben eingeführte Definition einer Entscheidung als einer thematisierten Selektion bedeutet auch, dass Entscheidungen kommunikative Ereignisse sind, die zugeschrieben werden müssen, um sozial wirksam zu werden. Aber es ist keineswegs so, dass diese Zuschreibung stets menschliche Akteure und nicht auch nicht-menschliche Aktanten adressiert. Bei Dispositionskrediten ist es sogar schon sozial weitgehend akzeptiert und mit Blick auf die Legitimation der Entscheidung sogar förderlich, dass hier Bankomaten ‚entscheiden‘ – ihnen also die Entscheidung zugeschrieben wird, bei einem bestimmten Kontostand keine Scheine mehr auszugeben.[29] Tatsächlich ist der Bankomat aber nur ein Partizipand in einem Netzwerk, das auch Menschen integriert. Menschen haben ihn gebaut und programmiert, lassen ihm aber bei dieser Art von Entscheidungen gerne den Vortritt.

Algorithmen produzieren bei den von O’Neil beschriebenen Entscheidungsprozessen immer wieder wegweisende Selektionen. Gleichwohl können sich die Algorithmen nur durch menschliche Vermittlung an der Herstellung von Entscheidungen – also von thematisierten, kommunikativ vermittelten Selektionen – beteiligen. Umgekehrt bleibt aber auch die Rückkehr zu einem ‚rein‘ menschlichen Entscheiden eine Fiktion oder sogar eine Utopie, die im Kontrast steht zu historischen und gegenwärtigen Praktiken des Entscheidens, an der immer schon Artefakte beteiligt waren.[30]

[1] O’Neil, Cathy, Weapons of math destruction. How big data increases inequality and threatens democracy, New York 2016.

[2] Die deutsche Version ist unter dem Titel „Angriff der Algorithmen: Wie sie Wahlen manipulieren, Berufschancen zerstören und unsere Gesundheit gefährden“ (München 2017) erschienen und mittlerweile auch bei der Bundeszentrale für politische Bildung greifbar.

[3] Cathrin Gilbert: Handeldefizit. In: Zeitmagazin Nr. 44/2017.

[4] Vgl. zur aktuellen Diskussion: Julia Krüger: Wie der Mensch die Kontrolle über den Algorithmus behalten kann. In: netzpolitik.org; Yannick Lebert: Algorithmen entscheiden über Leben. Zeit, sie zu regulieren. In: netzpolitik.org; Markus Beckedahl: Algorithmische Entscheidungsfindung: Handlungsbedarf und Lösungsansätze in der Übersicht. In: netzpolitik.org; Felix Rohrbeck: Die Wege des Algorithmus sind unergründlich. In: ZEIT ONLINE.

[5] So die Definition in der deutschsprachigen Ausgabe der Wikipedia. Die Verfasser beziehen sich ihrerseits auf die Definition der Informatiker Cormen, Thomas H. / Molitor, Paul, Algorithmen – eine Einführung, 3., überarb. und erw. Aufl., München 2010.

[6] Was ja nicht der Fall sein muss, aber in der aktuellen Diskussion geht es immer um computerbasierte Entscheidungen.

[7] Vgl. dazu demn. Hoffmann-Rehnitz, Philip / Krischer, André / Pohlig, Matthias, Entscheiden als Problem der Geschichtswissenschaft, in: Zeitschrift für Historische Forschung 45 (2018), im Druck.

[8] Ortmann, Günther, Als ob. Fiktionen und Organisationen, Wiesbaden 2004, 37.

[9] Ebd.

[10] Z.B. in einem Artikel über Einstellungsentscheidungen großer Firmen in The Economist.

[11] So etwa die Position der Informatikerin und Juristin Agata Królikowski im Interview auf dem Blog algorithmwatch.org.

[12] Vgl. allg. Schäfer, Hilmar, Praxistheorie als Kultursoziologie, in: Handbuch Kultursoziologie, hrsg. v. Stephan Moebius / Frithjof Nungesser / Katharina Scherke, Wiesbaden 2017, 1-22, und als Beispiele für die gegenwärtigen Interessen der historischen Kulturwissenschaften Füssel, Marian, Die Materialität der Frühen Neuzeit. Neuere Forschungen zur Geschichte der materiellen Kultur, in: Zeitschrift für Historische Forschung 42 (2015), 433-463; Keupp, Jan / Schmitz-Esser, Romerio (Hrsg.), Neue alte Sachlichkeit. Studienbuch Materialität des Mittelalters, Ostfildern 2015; kritisch aber zuletzt auch Keupp, Jan, Die Gegenstandslosigkeit des Materiellen. Was den material turn zum Abtörner macht , auf dem Mittelalter-Hypotheses-Blog.

[13] Kuri, Jürgen, Die Welt bleibt unberechenbar, in: Frankfurter Allgemeine Zeitung/126 (2010), 36.

[14] Hinweise auf solche Auffassungen (ohne sie zu teilen) finden sich bei Conradi, Tobias; Hoof, Florian; Nohr, Rolf F., Medien der Entscheidung. Einleitung, in: Medien der Entscheidung, hrsg. v. Tobias Conradi / Florian Hoof / Rolf F. Nohr (Medien’Welten 27), Berlin 2016, 7–22, 12.

[15] Latour, Bruno, Eine neue Soziologie für eine neue Gesellschaft. Einführung in die Akteur-Netzwerk-Theorie, Frankfurt am Main 2007, 123.

[16] Ich folge hier der ANT-Kritik und den Positionen von Schmidt, Robert, Soziologie der Praktiken. Konzeptionelle Studien und empirische Analysen, Berlin 2012, 68f., und Hirschauer, Stefan, Praktiken und ihre Körper. Über materielle Partizipanden des Tuns, in: Doing Culture. Neue Positionen zum Verhältnis von Kultur und sozialer Praxis, hrsg. v. Julia Reuter / Karl H. Hörning (Sozialtheorie), Bielefeld 2004, 73-91, 74. Hirschauer hat auch den Begriff „Partizipand“ (anstelle von Handelnder, Akteur oder Aktant) in die Diskussion eingebracht.

[17] Dieser Begriff des Entscheidens ist das Ergebnis der Diskussionen mit meinen Kollegen Alexander Durben, Benedikt Nientied und Matthias Friedmann. Es handelt sich hier nicht um den ‚offiziellen‘ Begriff des Entscheidens des SFBs.

[18] Luhmann, Niklas, Zur Komplexität von Entscheidungssituationen, in: Soziale Systeme 15 (2009), 3-35, hier 5.

[19] Schmidt, Soziologie der Praktiken, 68.

[20] Scheffer, Thomas, Diskurspraxis in Recht und Politik. Trans-Sequentialität und die Analyse rechtsförmiger Verfahren, in: Zeitschrift für Rechtssoziologie 35 (2015), 223-244.

[21] Latour, Bruno, Die Hoffnung der Pandora. Untersuchungen zur Wirklichkeit der Wissenschaft, Frankfurt am Main 2000, 221.

[22] Versteht man auch den Körper als Partizipanden, dann entpuppt sich auch ein individuelles Entscheiden als ein koaktiver Vollzug, aber das ist ein anderes und komplexes Thema, das gesondert behandelt werden muss.

[23] Software als Artefakt nennt etwa Schäfer, Praxistheorie als Kultursoziologie, 12.

[24] Luhmann, Niklas, Recht und Automation in der öffentlichen Verwaltung. Eine verwaltungswissenschaftliche Untersuchung (Schriftenreihe der Hochschule Speyer 29), 2., unveränd. Aufl., Berlin 1997.

[25] Ich beziehe mich hier auf seinen Vortrag „Deciding on Creditworthiness – Changing Prospects on Solvency“ auf der Tagung des SFB 1150 „Decision Making in the Realm of Finance – Interdisciplinary Conversations“, Münster 21.-22. 06.2018.

[26] Zur Interaktionsfähigkeit von Algorithmen vgl MacKenzie, Donald, How algorithms interact. Goffman’s ‘interaction order’in automated trading, Edinburgh 2016.

[27] ANT-nahe Forschungen sehen in einer derartigen Vernetzung einen Akteur, so etwa Hardie, Iain / MacKenzie, Donald, Assembling an Economic Actor. The Agencement of a Hedge Fund, in: The Sociological Review 55/1 (2017), 57-80.

[28] Vgl. Anm. 4.

[29] So heißt es bei Wikipedia über Kreditentscheidungen: „Der Entscheidungsprozess einer Kreditentscheidung verläuft ablauforganisatorisch unterschiedlich, je nachdem, ob es sich um Mengengeschäft oder Unternehmensfinanzierung handelt: Im Mengengeschäft (Dispositionskredite, Konsumkredite) geschieht dies vollautomatisiert nach einem Standardverfahren und führt zu einer sofortigen Kreditentscheidung“.

[30] Zum Mythos der ‚reinen‘ Entscheidung am Beispiel des Rechts vgl. Steinhauer, Fabian, Unreine Rechtslehren. Bruno Latours Untersuchung zum Conseil d’Ètat und der neue Materialismus in den Rechtswissenschaften, in: Der Staat 56 (2017), 293-304. Als Beispiel für eine Utopie rein menschlicher Handlungsmacht steht das neues Buch von Precht, David Richard, Jäger, Hirten, Kritiker. Eine Utopie für die digitale Gesellschaft, München 2018.